소비자 직접 유전자검사(DTC, Direct-To-Consumer)는 소비자가 의료기관을 거치지 않고 직접 유전자검사 기관을 통해 자신의 유전 정보를 확인할 수 있는 서비스입니다. 이 글에서는 한국에서 DTC 유전자검사의 허용 범위와 규제, 그리고 해외와의 차이점에 대해 설명합니다.

1. DTC 유전자검사의 목적

DTC 유전자검사는 개인의 유전 정보를 바탕으로 건강 관리와 생활 습관 개선을 돕는 것을 주요 목적으로 합니다. 특히, 질병 위험도를 직접적으로 다루는 대신 생활 습관 및 웰니스와 관련된 항목을 중점적으로 분석하여 개인의 건강 관리에 유용한 정보를 제공합니다.

DTC 유전자검사의 주요 목적은 다음과 같습니다.

- 건강 관리: 유전자형 정보를 통해 개인의 건강 관리 방안을 제안합니다.

- 생활 습관 개선: 영양, 운동, 피부 특성 등을 고려하여 맞춤형 생활 습관 개선을 돕습니다.

- 개인 맞춤형 서비스: 유전적 특성을 반영한 맞춤형 영양 섭취나 운동 방법을 추천합니다.

2. 한국에서의 DTC 유전자검사 항목과 제한

보건복지부는 한국에서의 DTC 유전자검사 항목을 엄격히 규제하고 있으며, 생활 습관 및 웰니스와 관련된 항목만 허용됩니다. 2023년 기준으로 총 165개의 항목이 고시되었으며, 이는 개인의 건강 관리와 생활 습관 개선에 중점을 둔 항목으로 구성되어 있습니다. 질병의 진단이나 치료 목적의 검사는 불허되며, 의료기관을 통해서만 진행할 수 있습니다.

허용된 주요 항목은 다음과 같습니다.

- 영양소 관련: 비타민 D, 오메가-3 지방산, 나트륨 배출

- 운동 및 신체 특성: 심폐 지구력, 근력, 골강도

- 피부 및 모발 특성: 피부 노화, 탈모, 색소 침착

- 식습관 및 대사: 카페인 대사, 알코올 분해 능력

- 기타 개인 특성: 왼손/오른손잡이, 후각 민감도

출처: 보건복지부, “소비자대상직접시행(DTC) 유전자검사항목 165개로 확대” (mohw.go.kr)

3. 한국과 해외 DTC 유전자검사의 차이점

3.1 검사 항목 및 규제 차이

- 한국: 주로 웰니스와 생활 습관 관련 항목에 국한되며, 질병 예측을 위한 검사는 불가능합니다.

- 해외: 미국과 유럽 일부 국가에서는 특정 질병의 유전자형을 검사해 알츠하이머, 파킨슨병 등의 위험도를 제공하는 경우도 있습니다. 예를 들어, 미국의 23andMe는 FDA 승인을 받은 검사를 통해 질병 위험도 정보를 제공할 수 있습니다.

3.2 검사 결과 해석의 차이

- 한국: 결과를 건강 관리 참고 자료로 사용할 수 있도록 단순화하여 제공하며, 소비자가 이를 바탕으로 전문가의 도움을 받을 수 있습니다.

- 해외: 미국에서는 질병 위험도 정보를 포함하여 소비자가 질병 예방 및 건강 관리에 활용할 수 있도록 상세한 해석을 제공합니다.

4. DTC 유전자검사에서의 SNP 선택과 규제

한국에서는 DTC 검사 항목뿐만 아니라 각 항목에 대해 분석할 SNP도 규제하고 있습니다. 보건복지부가 지정한 인증 항목 내에서 승인된 SNP만 검사가 가능하며, 검사기관이 임의로 SNP를 선택할 수 없습니다. 이는 검사 신뢰성과 소비자 보호를 위한 조치로, 검사가 규정된 범위 내에서만 이루어지도록 제한합니다.

5. 전통적 분석, 머신러닝, 딥러닝을 활용한 유전자형 분석

- 1. 전통적 통계 방법: Odds Ratio와 로지스틱 회귀Odds Ratio (OR)

2. 머신러닝 기반 모델: 랜덤 포레스트와 Gradient Boosting랜덤 포레스트 (Random Forest)

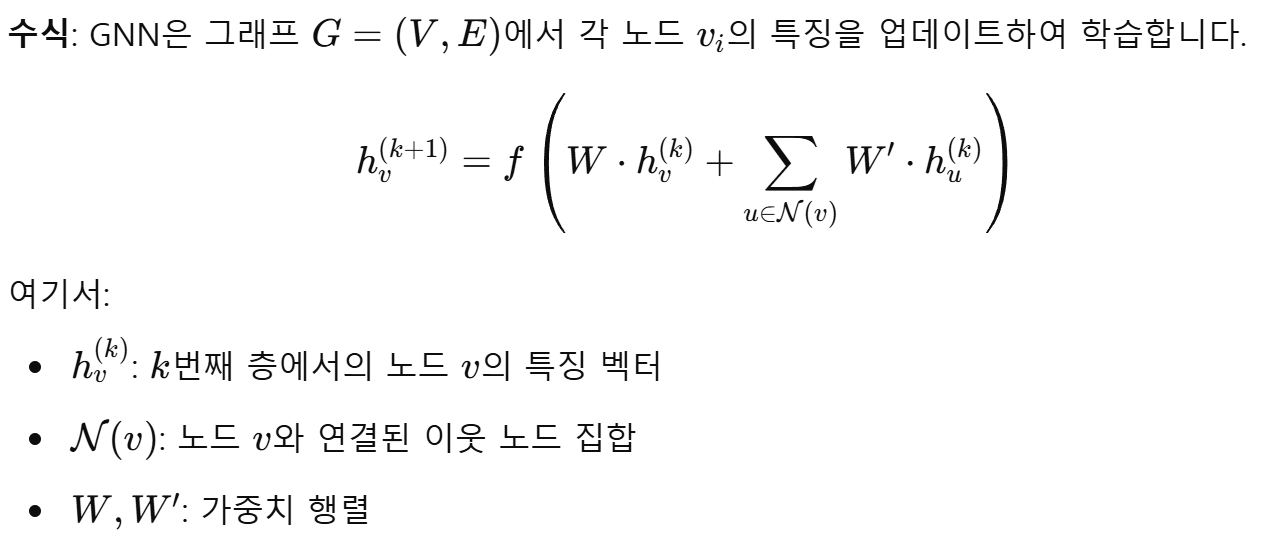

3. 딥러닝 기반 모델: CNN과 GNNConvolutional Neural Networks (CNN)

각 방법론은 SNP와 표현형 간의 상관관계를 파악하는 방식과 능력에 차이가 있습니다. 전통적 방법은 해석이 쉽고, 머신러닝은 비선형 패턴을 일부 반영할 수 있으며, 딥러닝은 복잡한 비선형 패턴과 LD 패턴을 포괄적으로 학습할 수 있지만, 해석력과 데이터 요구량에서 각각의 장단점이 있습니다.요약 비교방법론 해석력 비선형 패턴 학습 LD 패턴 반영데이터 요구량 전통적 통계 (OR, 로지스틱 회귀) 높음 낮음 제한적 적은 데이터에서도 가능 머신러닝 (랜덤 포레스트, Gradient Boosting) 중간 중간 일부 반영 중간 딥러닝 (CNN, GNN) 낮음 매우 높음 고도 반영 대규모 데이터 필요

요약

한국에서의 DTC 유전자검사는 소비자의 건강 관리와 생활 습관 개선에 초점을 맞추고 있으며, 지정된 항목과 SNP만 검사할 수 있도록 규제되어 있습니다. 반면, 해외에서는 질병 위험도 평가까지 허용되기도 하며, 더 많은 정보와 해석을 제공합니다. 전통적인 통계 방법에서부터 머신러닝, 딥러닝에 이르기까지 다양한 분석 방법론이 있으며, 각 방법의 장단점에 따라 유전자형과 표현형 간의 상관관계를 분석하는 방식이 달라질 수 있습니다.

'bioinformatics' 카테고리의 다른 글

| Ubuntu 20.04에서 최신 버전 Slurm 수동 설치 방법 (0) | 2025.02.11 |

|---|---|

| 생존 분석(Survival Analysis) 개요 (0) | 2025.02.04 |

| 멀티오믹스 분석 주제와 활용할 수 있는 공공 데이터베이스 (3) | 2024.10.29 |

| NGS 데이터 분석에서 PHRED Quality Score 이해하기 (0) | 2024.10.27 |

| Argo workflow를 사용한 파이프라인 관리 (0) | 2024.09.22 |